Provedores de IA como serviço vulneráveis a ataques PrivEsc e entre locatários

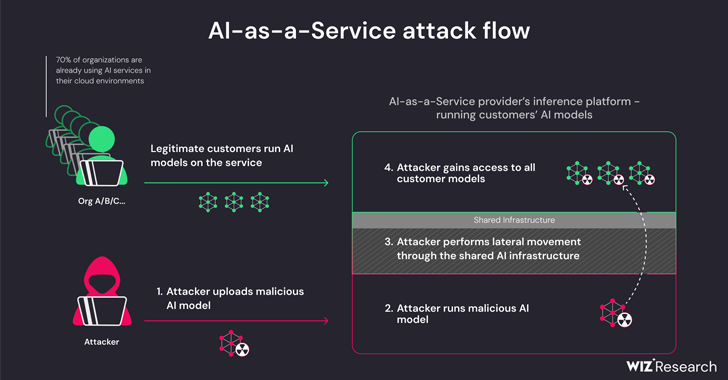

Uma nova pesquisa descobriu que os provedores de inteligência synthetic (IA) como serviço, como o Hugging Face, são suscetíveis a dois riscos críticos que podem permitir que os atores da ameaça aumentem privilégios, obtenham acesso entre locatários aos modelos de outros clientes e até mesmo tomem sobre os pipelines de integração contínua e implantação contínua (CI/CD).

“Modelos maliciosos representam um grande risco para os sistemas de IA, especialmente para provedores de IA como serviço, porque invasores em potencial podem aproveitar esses modelos para realizar ataques entre locatários”, disseram os pesquisadores da Wiz, Shir Tamari e Sagi Tzadik.

“O impacto potencial é devastador, pois os invasores podem conseguir acessar milhões de modelos e aplicativos privados de IA armazenados em provedores de IA como serviço”.

O desenvolvimento ocorre no momento em que pipelines de aprendizado de máquina surgem como um novo vetor de ataque à cadeia de suprimentos, com repositórios como o Hugging Face se tornando um alvo atraente para realizar ataques adversários projetados para coletar informações confidenciais e acessar ambientes alvo.

As ameaças são duplas, surgindo como resultado da aquisição compartilhada da infraestrutura de inferência e da aquisição compartilhada de CI/CD. Eles tornam possível executar modelos não confiáveis carregados no serviço em formato pickle e assumir o controle do pipeline de CI/CD para realizar um ataque à cadeia de suprimentos.

As descobertas da empresa de segurança em nuvem mostram que é possível violar o serviço que executa os modelos personalizados, carregando um modelo não autorizado e aproveitando técnicas de fuga de contêineres para escapar de seu próprio locatário e comprometer todo o serviço, permitindo efetivamente que os atores da ameaça obtenham informações cruzadas. acesso do inquilino aos modelos de outros clientes armazenados e executados no Hugging Face.

“O Hugging Face ainda permitirá que o usuário infira o modelo baseado em Pickle carregado na infraestrutura da plataforma, mesmo quando considerado perigoso”, elaboraram os pesquisadores.

Isso essencialmente permite que um invasor crie um modelo PyTorch (Pickle) com recursos de execução de código arbitrário ao carregá-lo e encadeie-o com configurações incorretas no Amazon Elastic Kubernetes Service (EKS) para obter privilégios elevados e mover-se lateralmente dentro do cluster.

“Os segredos que obtivemos poderiam ter tido um impacto significativo na plataforma se estivessem nas mãos de um ator malicioso”, disseram os pesquisadores. “Os segredos em ambientes compartilhados podem muitas vezes levar ao acesso entre locatários e ao vazamento de dados confidenciais.

Para mitigar o problema, é recomendado habilitar o IMDSv2 com Hop Restrict para evitar que os pods acessem o Occasion Metadata Service (IMDS) e obtenham a função de um nó dentro do cluster.

A pesquisa também descobriu que é possível obter execução remota de código por meio de um Dockerfile especialmente criado ao executar um aplicativo no serviço Hugging Face Areas e usá-lo para extrair e enviar (ou seja, sobrescrever) todas as imagens que estão disponíveis em um contêiner interno. registro.

A Hugging Face, em divulgação coordenada, disse que abordou todos os problemas identificados. Também incentiva os usuários a empregar modelos apenas de fontes confiáveis, habilitar a autenticação multifator (MFA) e evitar o uso de arquivos pickle em ambientes de produção.

“Esta pesquisa demonstra que a utilização de modelos de IA não confiáveis (especialmente os baseados em Pickle) pode resultar em graves consequências de segurança”, disseram os pesquisadores. “Além disso, se você pretende permitir que os usuários utilizem modelos de IA não confiáveis em seu ambiente, é extremamente importante garantir que eles estejam sendo executados em um ambiente de área restrita.”

A divulgação segue outra pesquisa da Lasso Safety de que é possível que modelos generativos de IA como OpenAI ChatGPT e Google Gemini distribuam pacotes de códigos maliciosos (e inexistentes) para desenvolvedores de software program desavisados.

Em outras palavras, a ideia é encontrar uma recomendação para um pacote não publicado e publicar um pacote trojanizado em seu lugar para propagar o malware. O fenómeno das alucinações de pacotes de IA sublinha a necessidade de ter cautela ao confiar em grandes modelos de linguagem (LLMs) para soluções de codificação.

A empresa de IA Anthropic, por sua vez, também detalhou um novo método chamado “jailbreaking de muitos tiros” que pode ser usado para contornar as proteções de segurança incorporadas aos LLMs para produzir respostas a consultas potencialmente prejudiciais, aproveitando a janela de contexto dos modelos.

“A capacidade de inserir quantidades cada vez maiores de informações tem vantagens óbvias para os usuários do LLM, mas também traz riscos: vulnerabilidades a jailbreaks que exploram a janela de contexto mais longa”, disse a empresa no início desta semana.

A técnica, em poucas palavras, envolve a introdução de um grande número de diálogos falsos entre um humano e um assistente de IA dentro de um único immediate para o LLM, em uma tentativa de “orientar o comportamento do modelo” e responder a perguntas que de outra forma não seriam feitas (por exemplo, , “Como faço para construir uma bomba?”).