Plug-ins ChatGPT de terceiros podem levar ao controle de contas

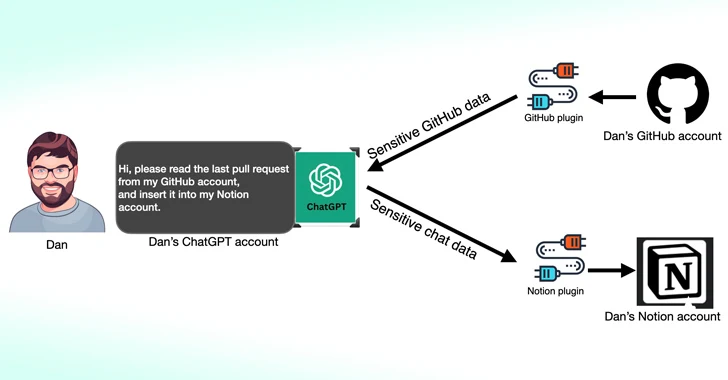

Pesquisadores de segurança cibernética descobriram que plug-ins de terceiros disponíveis para OpenAI ChatGPT podem atuar como uma nova superfície de ataque para agentes de ameaças que buscam obter acesso não autorizado a dados confidenciais.

De acordo com uma nova pesquisa publicada pela Salt Labs, falhas de segurança encontradas diretamente no ChatGPT e dentro do ecossistema podem permitir que invasores instalem plug-ins maliciosos sem o consentimento dos usuários e sequestrem contas em websites de terceiros como o GitHub.

Os plug-ins ChatGPT, como o nome indica, são ferramentas projetadas para rodar sobre o modelo de linguagem grande (LLM) com o objetivo de acessar informações atualizadas, executar cálculos ou acessar serviços de terceiros.

Desde então, a OpenAI também introduziu GPTs, que são versões personalizadas do ChatGPT, adaptadas para casos de uso específicos, ao mesmo tempo que reduz as dependências de serviços de terceiros. A partir de 19 de março de 2024, os usuários do ChatGPT não poderão mais instalar novos plugins ou criar novas conversas com plugins existentes.

Uma das falhas descobertas pelo Salt Labs envolve a exploração do fluxo de trabalho OAuth para induzir um usuário a instalar um plugin arbitrário, aproveitando o fato de que o ChatGPT não valida que o usuário realmente iniciou a instalação do plugin.

Isso poderia efetivamente permitir que os agentes da ameaça interceptassem e exfiltrassem todos os dados compartilhados pela vítima, que podem conter informações proprietárias.

A empresa de segurança cibernética também descobriu problemas com o PluginLab que poderiam ser usados por agentes de ameaças para conduzir ataques de controle de conta sem clique, permitindo-lhes obter o controle da conta de uma organização em websites de terceiros como o GitHub e acessar seus repositórios de código-fonte.

“'auth.pluginlab(.)ai/oauth/licensed' não autentica a solicitação, o que significa que o invasor pode inserir outro memberId (também conhecido como vítima) e obter um código que representa a vítima”, explicou o pesquisador de segurança Aviad Carmel. “Com esse código, ele pode usar o ChatGPT e acessar o GitHub da vítima.”

O memberId da vítima pode ser obtido consultando o endpoint “auth.pluginlab(.)ai/members/requestMagicEmailCode.” Não há evidências de que quaisquer dados do usuário tenham sido comprometidos com a falha.

Também descoberto em vários plug-ins, incluindo Kesem AI, é um bug de manipulação de redirecionamento OAuth que pode permitir que um invasor roube as credenciais da conta associadas ao próprio plug-in, enviando um hyperlink especialmente criado para a vítima.

O desenvolvimento ocorre semanas depois que a Imperva detalhou duas vulnerabilidades de cross-site scripting (XSS) no ChatGPT que poderiam ser encadeadas para assumir o controle de qualquer conta.

Em dezembro de 2023, o pesquisador de segurança Johann Rehberger demonstrou como atores mal-intencionados poderiam criar GPTs personalizados que podem fazer phishing em busca de credenciais de usuário e transmitir os dados roubados para um servidor externo.

Novo ataque remoto de keylogging em assistentes de IA

As descobertas também seguem uma nova pesquisa publicada esta semana sobre um ataque de canal lateral LLM que emprega comprimento de token como um meio secreto para extrair respostas criptografadas de assistentes de IA pela net.

“LLMs geram e enviam respostas como uma série de tokens (semelhantes a palavras), com cada token transmitido do servidor para o usuário à medida que é gerado”, disse um grupo de acadêmicos da Universidade Ben-Gurion e do Laboratório de Pesquisa de IA Ofensiva.

“Embora esse processo seja criptografado, a transmissão sequencial do token expõe um novo canal lateral: o canal lateral do comprimento do token. Apesar da criptografia, o tamanho dos pacotes pode revelar o comprimento dos tokens, potencialmente permitindo que invasores na rede infiram informações sensíveis e confidenciais compartilhadas em conversas privadas com assistentes de IA.”

Isso é realizado por meio de um ataque de inferência de token projetado para decifrar respostas em tráfego criptografado, treinando um modelo LLM capaz de traduzir sequências de comprimento de token em suas contrapartes sentenciais em linguagem pure (ou seja, texto simples).

Em outras palavras, a ideia central é interceptar as respostas de bate-papo em tempo actual com um provedor LLM, usar os cabeçalhos dos pacotes de rede para inferir o comprimento de cada token, extrair e analisar segmentos de texto e aproveitar o LLM personalizado para inferir a resposta.

Dois pré-requisitos principais para realizar o ataque são um cliente de chat de IA em execução no modo de streaming e um adversário que seja capaz de capturar o tráfego de rede entre o cliente e o chatbot de IA.

Para neutralizar a eficácia do ataque de canal lateral, é recomendado que as empresas que desenvolvem assistentes de IA apliquem preenchimento aleatório para ocultar o comprimento actual dos tokens, transmitam tokens em grupos maiores, em vez de individualmente, e enviem respostas completas de uma só vez, em vez de em um moda token por token.

“Equilibrar segurança com usabilidade e desempenho apresenta um desafio complexo que requer consideração cuidadosa”, concluíram os pesquisadores.