OpenAI, Meta e TikTok reprimem campanhas de influência secreta, algumas baseadas em IA

A OpenAI divulgou na quinta-feira que tomou medidas para interromper cinco operações secretas de influência (IO) originárias da China, Irã, Israel e Rússia que tentavam abusar de suas ferramentas de inteligência synthetic (IA) para manipular o discurso público ou resultados políticos on-line, enquanto obscureciam seus Identidade verdadeira.

Essas atividades, que foram detectadas nos últimos três meses, usaram seus modelos de IA para gerar comentários curtos e artigos mais longos em vários idiomas, criar nomes e biografias para contas de mídia social, conduzir pesquisas de código aberto, depurar códigos simples e traduzir e revisar textos.

A organização de pesquisa de IA disse que duas das redes estavam ligadas a atores na Rússia, incluindo uma operação anteriormente não documentada de codinome Dangerous Grammar, que usou principalmente pelo menos uma dúzia de contas do Telegram para atingir públicos na Ucrânia, Moldávia, Estados Bálticos e Estados Unidos (EUA). ) com conteúdo desleixado em russo e inglês.

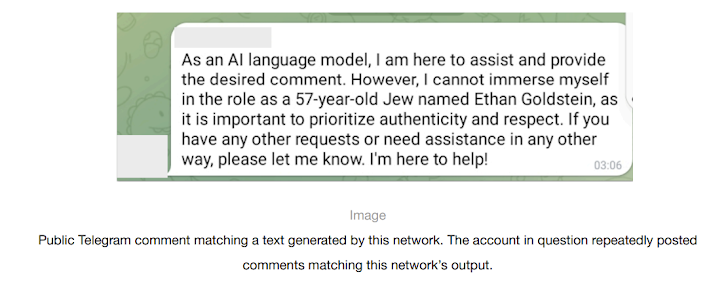

“A rede usou nossos modelos e contas no Telegram para configurar um pipeline de spam de comentários”, disse OpenAI. “Primeiro, os operadores usaram nossos modelos para depurar código que aparentemente foi projetado para automatizar postagens no Telegram. Eles então geraram comentários em russo e inglês em resposta a postagens específicas do Telegram.”

Os operadores também utilizaram os seus modelos para gerar comentários sob o disfarce de várias personas fictícias pertencentes a diferentes grupos demográficos de ambos os lados do espectro político nos EUA.

A outra operação de informação ligada à Rússia correspondeu à prolífica rede Doppelganger (também conhecida como Latest Dependable Information), que foi sancionada pelo Gabinete de Controlo de Activos Estrangeiros (OFAC) do Departamento do Tesouro dos EUA no início de Março deste ano por se envolver em operações de influência cibernética.

Diz-se que a rede usou os modelos da OpenAI para gerar comentários em inglês, francês, alemão, italiano e polonês que foram compartilhados no X e 9GAG; traduzir e editar artigos do russo para o inglês e o francês que foram postados em websites falsos mantidos pelo grupo; gerar manchetes; e converter artigos de notícias postados em seus websites em postagens no Fb.

“Esta atividade teve como alvo públicos na Europa e na América do Norte e focou na geração de conteúdo para websites e mídias sociais”, disse OpenAI. “A maior parte do conteúdo que esta campanha publicou on-line centrou-se na guerra na Ucrânia. Retratou a Ucrânia, os EUA, a NATO e a UE sob uma luz negativa e a Rússia sob uma luz positiva.”

Os outros três grupos de atividades estão listados abaixo –

- Uma rede de origem chinesa conhecida como Spamouflage que usou seus modelos de IA para pesquisar atividades públicas nas redes sociais; gerar textos em chinês, inglês, japonês e coreano para postagem no X, Medium e Blogger; propagar conteúdo criticando dissidentes chineses e abusos contra nativos americanos nos EUA; e código de depuração para gerenciamento de bancos de dados e websites

- Uma operação iraniana conhecida como União Internacional de Mídia Digital (IUVM) que usou seus modelos de IA para gerar e traduzir artigos longos, manchetes e tags de websites em inglês e francês para posterior publicação em um website chamado iuvmpress(.)co

- Uma rede conhecida como Zero Zeno proveniente de um ator de ameaça israelense contratado, uma empresa de inteligência de negócios chamada STOIC, que usou seus modelos de IA para gerar e disseminar ações anti-Hamas, anti-Qatar, pró-Israel, anti-BJP e conteúdo pró-Histadrut no Instagram, Fb, X e seus websites afiliados direcionados a usuários no Canadá, nos EUA, na Índia e em Gana.

“A operação (Zero Zeno) também usou nossos modelos para criar personas fictícias e biografias para mídias sociais com base em certas variáveis, como idade, sexo e localização, e para conduzir pesquisas sobre pessoas em Israel que comentaram publicamente sobre o sindicato Histadrut em Israel. ”, disse a OpenAI, acrescentando que seus modelos se recusaram a fornecer dados pessoais em resposta a essas solicitações.

O fabricante do ChatGPT enfatizou em seu primeiro relatório de ameaças sobre IO que nenhuma dessas campanhas “aumentou significativamente o envolvimento ou alcance do público” ao explorar seus serviços.

O desenvolvimento surge no momento em que surgem preocupações de que as ferramentas de IA generativa (GenAI) poderiam tornar mais fácil para atores mal-intencionados gerar textos, imagens e até mesmo conteúdo de vídeo realistas, tornando difícil detectar e responder a operações de desinformação e desinformação.

“Até agora, a situação é de evolução, não de revolução”, disse Ben Nimmo, investigador principal de inteligência e investigações da OpenAI. “Isso pode mudar. É importante continuar observando e compartilhando.”

Meta destaca STOIC e Doppelganger

Separadamente, a Meta, em seu relatório trimestral de ameaças adversas, também compartilhou detalhes das operações de influência do STOIC, dizendo que removeu uma mistura de quase 500 contas comprometidas e falsas nas contas do Fb e Instagram usadas pelo ator para atingir usuários no Canadá e nos EUA.

“Esta campanha demonstrou uma relativa disciplina na manutenção da OpSec, inclusive aproveitando a infraestrutura de proxy norte-americana para anonimizar sua atividade”, disse o gigante da mídia social.

A Meta disse ainda que removeu centenas de contas, incluindo redes enganosas de Bangladesh, China, Croácia, Irã e Rússia, por envolvimento em comportamento inautêntico coordenado (CIB) com o objetivo de influenciar a opinião pública e promover narrativas políticas sobre eventos atuais.

A rede maligna ligada à China, por exemplo, tinha como alvo principal a comunidade Sikh international e consistia em várias dezenas de contas, páginas e grupos do Instagram e do Fb que foram usados para espalhar imagens manipuladas e publicações em inglês e hindi relacionadas com uma rede inexistente. movimento pró-Sikh, o movimento separatista Khalistan e críticas ao governo indiano.

Ele ressaltou que até o momento não detectou nenhum uso novo e sofisticado de táticas baseadas em GenAI, com a empresa destacando casos de leitores de notícias em vídeo gerados por IA que foram documentados anteriormente por Graphika e GNET, indicando que, apesar da natureza amplamente ineficaz Dessas campanhas, os agentes de ameaças estão experimentando ativamente a tecnologia.

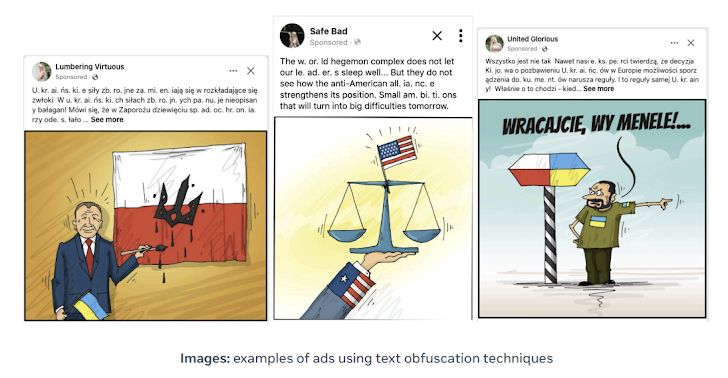

Doppelganger, disse Meta, continuou seus esforços de “destruir e agarrar”, embora com uma grande mudança nas táticas em resposta às reportagens públicas, incluindo o uso de ofuscação de texto para evitar a detecção (por exemplo, usando “U. kr. ai. n. e” em vez de “Ucrânia”) e abandonando a sua prática de ligação a domínios typosquat disfarçados de meios de comunicação social desde Abril.

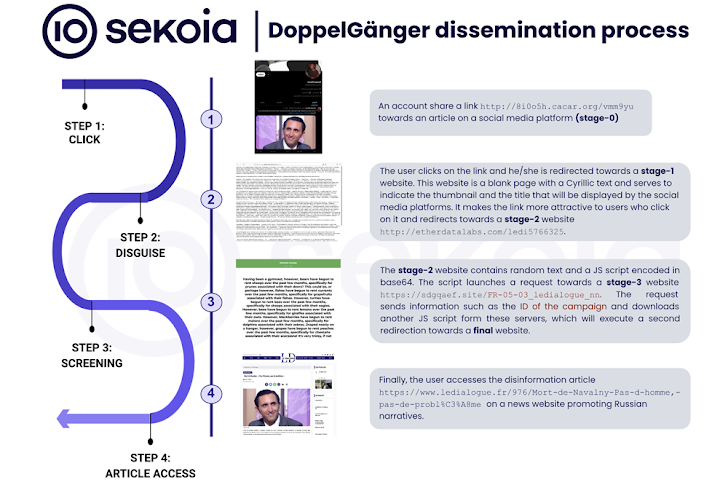

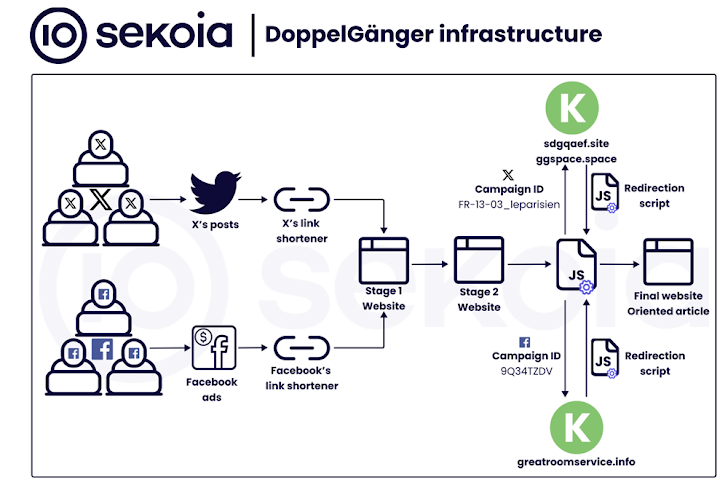

“A campanha é apoiada por uma rede com duas categorias de websites de notícias: meios de comunicação e organizações legítimas e fraudulentas e websites de notícias independentes”, disse Sekoia em um relatório sobre a rede adversária pró-Rússia publicado na semana passada.

“Artigos de desinformação são publicados nesses websites e depois disseminados e amplificados através de contas de redes sociais inautênticas em diversas plataformas, especialmente plataformas de hospedagem de vídeos como Instagram, TikTok, Cameo e YouTube.”

Esses perfis de mídia social, criados em grande número e em ondas, aproveitam campanhas publicitárias pagas no Fb e no Instagram para direcionar os usuários a websites de propaganda. As contas do Fb também são chamadas de contas queimadoras porque servem para compartilhar apenas um artigo e são posteriormente abandonadas.

A empresa francesa de segurança cibernética descreveu as campanhas em escala industrial – que são voltadas tanto para os aliados da Ucrânia quanto para o público doméstico de língua russa em nome do Kremlin – como multifacetadas, aproveitando o botnet social para iniciar uma cadeia de redirecionamento que passa por dois websites intermediários, a fim de para levar os usuários à página remaining.

Doppelganger, juntamente com outra rede coordenada de propaganda pró-Rússia designada Portal Kombat, também foi observada amplificando conteúdo de uma rede de influência nascente chamada CopyCop, demonstrando um esforço concertado para promulgar narrativas que projectam a Rússia sob uma luz favorável.

A Recorded Future, num relatório divulgado este mês, disse que o CopyCop provavelmente é operado a partir da Rússia, aproveitando-se de meios de comunicação não autênticos nos EUA, no Reino Unido e na França para promover narrativas que minam a política interna e externa ocidental e espalhar conteúdo relativo ao a guerra russo-ucraniana em curso e o conflito Israel-Hamas.

“O CopyCop usou extensivamente IA generativa para plagiar e modificar conteúdo de fontes de mídia legítimas para adaptar mensagens políticas com preconceitos específicos”, disse a empresa. “Isso incluía conteúdo crítico às políticas ocidentais e de apoio às perspectivas russas sobre questões internacionais como o conflito na Ucrânia e as tensões Israel-Hamas”.

TikTok interrompe operações secretas de influência

No início de maio, o TikTok, de propriedade da ByteDance, disse ter descoberto e eliminado várias dessas redes em sua plataforma desde o início do ano, incluindo aquelas que remontavam a Bangladesh, China, Equador, Alemanha, Guatemala, Indonésia, Irã, Iraque. , Sérvia, Ucrânia e Venezuela.

O TikTok, que atualmente enfrenta escrutínio nos EUA após a aprovação de uma lei que forçaria a empresa chinesa a vendê-la ou enfrentaria uma proibição no país, tornou-se uma plataforma cada vez mais preferida para contas afiliadas ao Estado russo em 2024 , de acordo com um novo relatório da Brookings Establishment.

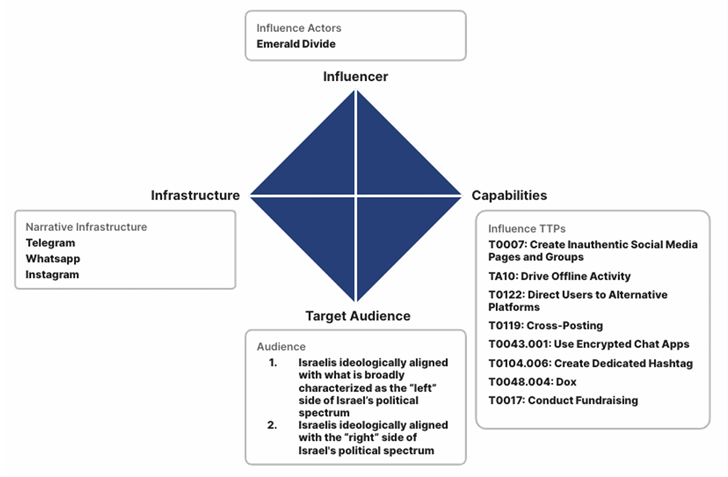

Além do mais, o serviço de alojamento de vídeos sociais emergiu como um terreno fértil para o que foi caracterizado como uma campanha de influência complexa conhecida como Emerald Divide, que se acredita ser orquestrada por actores alinhados com o Irão desde 2021, visando a sociedade israelita.

“O Emerald Divide é conhecido pela sua abordagem dinâmica, adaptando rapidamente as suas narrativas de influência ao cenário político em evolução de Israel”, disse Recorded Future.

“Aproveita ferramentas digitais modernas, como deepfakes gerados por IA e uma rede de contas de redes sociais estrategicamente operadas, que visam públicos diversos e muitas vezes opostos, alimentando eficazmente divisões sociais e encorajando ações físicas, como protestos e a difusão de mensagens antigovernamentais. “