AnimateLCM: Acelerando a animação de modelos de difusão personalizados

Nos últimos anos, os modelos de difusão alcançaram enorme sucesso e reconhecimento para tarefas de geração de imagens e vídeos. Os modelos de difusão de vídeo, em explicit, têm ganhado atenção significativa devido à sua capacidade de produzir vídeos com alta coerência e também fidelidade. Esses modelos geram vídeos de alta qualidade empregando um processo iterativo de remoção de ruído em sua arquitetura que transforma gradualmente o ruído gaussiano de alta dimensão em dados reais.

A Difusão Estável é um dos modelos mais representativos para tarefas de geração de imagens, contando com um AutoEncoder Variacional (VAE) para mapear entre a imagem actual e os recursos latentes com amostragem reduzida. Isso permite que o modelo reduza os custos de geração, enquanto o mecanismo de atenção cruzada em sua arquitetura facilita a geração de imagens condicionadas por texto. Mais recentemente, a estrutura Steady Diffusion construiu a base para vários adaptadores plug-and-play para obter uma geração de imagem ou vídeo mais inovadora e eficaz. No entanto, o processo generativo iterativo empregado pela maioria dos modelos de difusão de vídeo torna o processo de geração de imagem demorado e comparativamente caro, limitando suas aplicações.

Neste artigo falaremos sobre o AnimateLCM, um modelo de difusão personalizado com adaptadores que visa gerar vídeos de alta fidelidade com mínimos passos e custos computacionais. A estrutura AnimateLCM é inspirada no Modelo de Consistência, que acelera a amostragem com etapas mínimas, destilando modelos de difusão de imagens pré-treinados. Além disso, a extensão bem-sucedida do Modelo de Consistência, o Modelo de Consistência Latente (LCM), facilita a geração de imagens condicionais. Em vez de conduzir o aprendizado de consistência diretamente no conjunto de dados de vídeo bruto, a estrutura do AnimateLCM propõe o uso de uma estratégia de aprendizado de consistência desacoplada. Esta estratégia desacopla a destilação de anteriores de geração de movimento e anteriores de geração de imagem, permitindo ao modelo melhorar a qualidade visible do conteúdo gerado e melhorar a eficiência do treinamento simultaneamente. Além disso, o modelo AnimateLCM propõe adaptadores de treinamento do zero ou adaptação de adaptadores existentes ao seu modelo de consistência de vídeo destilado. Isso facilita a combinação de adaptadores plug-and-play na família de modelos de difusão estáveis para alcançar diferentes funções sem prejudicar a velocidade da amostra.

Este artigo tem como objetivo abordar em profundidade a estrutura do AnimateLCM. Exploramos o mecanismo, a metodologia e a arquitetura da estrutura, juntamente com sua comparação com estruturas de geração de imagem e vídeo de última geração. Então vamos começar.

Os modelos de difusão têm sido a estrutura ideally suited para tarefas de geração de imagens e vídeos devido à sua eficiência e capacidades em tarefas generativas. A maioria dos modelos de difusão depende de um processo iterativo de remoção de ruído para geração de imagens que transforma gradualmente um ruído gaussiano de alta dimensão em dados reais. Embora o método forneça resultados um tanto satisfatórios, o processo iterativo e o número de amostras iterativas retardam o processo de geração e também aumentam os requisitos computacionais dos modelos de difusão que são muito mais lentos do que outras estruturas generativas como GAN ou Redes Adversariais Generativas. Nos últimos anos, Modelos de Consistência ou CMs têm sido propostos como uma alternativa aos modelos de difusão iterativos para acelerar o processo de geração e manter constantes os requisitos computacionais.

O destaque dos modelos de consistência é que eles aprendem mapeamentos de consistência que mantêm a autoconsistência das trajetórias introduzidas pelos modelos de difusão pré-treinados. O processo de aprendizagem dos Modelos de Consistência permite gerar imagens de alta qualidade com etapas mínimas e também elimina a necessidade de iterações com uso intensivo de computação. Além disso, o Modelo de Consistência Latente ou LCM construído sobre a estrutura de difusão estável pode ser integrado à interface do usuário da net com os adaptadores existentes para obter uma série de funcionalidades adicionais, como tradução de imagem para imagem em tempo actual. Em comparação, embora os modelos de difusão de vídeo existentes forneçam resultados aceitáveis, ainda há progresso a ser feito no campo da aceleração de amostras de vídeo, e isso é de grande importância devido aos altos custos computacionais de geração de vídeo.

Isso nos leva ao AnimateLCM, um framework de geração de vídeo de alta fidelidade que precisa de um número mínimo de etapas para as tarefas de geração de vídeo. Seguindo o modelo de consistência latente, a estrutura AnimateLCM trata o processo de difusão reversa como a resolução de fluxo de probabilidade aumentada CFG ou Classifier Free Steerage e treina o modelo para prever a solução de tais fluxos de probabilidade diretamente no espaço latente. No entanto, em vez de conduzir diretamente o aprendizado de consistência em dados brutos de vídeo, o que requer alto treinamento e recursos computacionais, e muitas vezes leva a baixa qualidade, a estrutura AnimateLCM propõe uma estratégia de aprendizado consistente dissociado que dissocia a destilação de consistência da geração de movimento e da geração de imagem anterior.

A estrutura AnimateLCM primeiro conduz a destilação de consistência para adaptar o modelo de difusão de base de imagem ao modelo de consistência de imagem e, em seguida, conduz a inflação 3D para os modelos de consistência de imagem e de difusão de imagem para acomodar recursos 3D. Eventualmente, a estrutura AnimateLCM obtém o modelo de consistência de vídeo conduzindo a destilação de consistência nos dados de vídeo. Além disso, para aliviar a possível corrupção de recursos como resultado do processo de difusão, a estrutura do AnimateLCM também propõe o uso de uma estratégia de inicialização. Como a estrutura AnimateLCM é construída sobre a estrutura Steady Diffusion, ela pode substituir os pesos espaciais de seu modelo de consistência de vídeo treinado pelos pesos de difusão de imagem personalizados disponíveis publicamente para obter resultados de geração inovadores.

Além disso, para treinar adaptadores específicos do zero ou para se adequar melhor aos adaptadores disponíveis publicamente, a estrutura AnimateLCM propõe uma estratégia de aceleração eficaz para os adaptadores que não requerem treinamento de modelos específicos de professores.

As contribuições da estrutura AnimateLCM podem ser muito bem resumidas como: A estrutura AnimateLCM proposta visa alcançar geração de vídeo de alta qualidade, rápida e de alta fidelidade e, para conseguir isso, a estrutura AnimateLCM propõe uma estratégia de destilação desacoplada que desacopla o movimento e a imagem gerações anteriores, resultando em melhor qualidade de geração e maior eficiência de treinamento.

InstantID: Metodologia e Arquitetura

Em sua essência, a estrutura InstantID se inspira fortemente em modelos de difusão e estratégias de velocidade de amostragem. Os modelos de difusão, também conhecidos como modelos generativos baseados em pontuação, demonstraram notáveis capacidades de geração de imagens. Sob a orientação da direção da pontuação, a estratégia de amostragem iterativa implementada pelos modelos de difusão elimina gradualmente o ruído dos dados corrompidos pelo ruído. A eficiência dos modelos de difusão é uma das principais razões pelas quais eles são empregados pela maioria dos modelos de difusão de vídeo, treinando em camadas temporais adicionadas. Por outro lado, as estratégias de velocidade de amostragem e aceleração de amostragem ajudam a lidar com as lentas velocidades de geração em modelos de difusão. O método de aceleração baseado em destilação ajusta os pesos de difusão originais com uma arquitetura ou escalonador refinado para aumentar a velocidade de geração.

Seguindo em frente, a estrutura do InstantID é construída sobre o modelo de difusão estável que permite ao InstantID aplicar noções relevantes. O modelo trata o processo de difusão direta discreta como SDE de preservação de variância em tempo contínuo. Além disso, o modelo de difusão estável é uma extensão do DDPM ou Modelo Probabilístico de Difusão Denoising, no qual o ponto de dados de treinamento é perturbado gradualmente pela cadeia discreta de Markov com um canil de perturbação permitindo a distribuição de dados ruidosos em diferentes intervalos de tempo para seguir a distribuição.

Para obter geração de vídeo de alta fidelidade com um número mínimo de etapas, a estrutura AnimateLCM domestica os modelos de vídeo estáveis baseados em difusão para seguir a propriedade de autoconsistência. A estrutura geral de treinamento da estrutura AnimateLCM consiste em uma estratégia de aprendizagem consistente dissociada para adaptação livre do professor e aprendizagem consistente eficaz.

Transição de modelos de difusão para modelos de consistência

A estrutura AnimateLCM introduz sua própria adaptação do Modelo de Difusão Estável ou DM para o Modelo de Consistência ou CM seguindo o design do Modelo de Consistência Latente ou LCM. Vale a pena notar que embora os modelos de difusão estável normalmente prevejam o ruído adicionado às amostras, eles são modelos de difusão sigma essenciais. Contrasta com modelos de consistência que visam prever diretamente a solução para a trajetória PF-ODE. Além disso, em modelos de difusão estáveis com determinados parâmetros, é essencial que o modelo empregue uma estratégia de orientação livre de classificador para gerar imagens de alta qualidade. A estrutura AnimateLCM, no entanto, emprega um solucionador ODE aumentado de orientação sem classificador para amostrar os pares adjacentes nas mesmas trajetórias, resultando em melhor eficiência e qualidade aprimorada. Além disso, os modelos existentes indicaram que a qualidade da geração e a eficiência do treinamento são fortemente influenciadas pelo número de pontos discretos na trajetória. Um número menor de pontos discretos acelera o processo de treinamento, enquanto um número maior de pontos discretos resulta em menos viés durante o treinamento.

Aprendizagem de consistência dissociada

Para o processo de destilação de consistência, os desenvolvedores observaram que os dados utilizados para treinamento influenciam fortemente a qualidade da geração closing dos modelos de consistência. No entanto, o principal problema com os conjuntos de dados disponíveis publicamente atualmente é que muitas vezes consistem em dados de marca d’água ou são de baixa qualidade e podem conter legendas excessivamente breves ou ambíguas. Além disso, treinar o modelo diretamente em vídeos de grande resolução é computacionalmente caro e demorado, tornando-o uma opção inviável para a maioria dos pesquisadores.

Dada a disponibilidade de conjuntos de dados filtrados de alta qualidade, a estrutura AnimateLCM propõe dissociar a destilação dos anteriores de movimento e dos anteriores de geração de imagem. Para ser mais específico, a estrutura AnimateLCM primeiro destila os modelos de difusão estáveis em modelos de consistência de imagem com conjuntos de dados de texto de imagem filtrados de alta qualidade com melhor resolução. A estrutura então treina os pesos leves do LoRA nas camadas do modelo de difusão estável, congelando assim os pesos do modelo de difusão estável. Uma vez que o modelo ajusta os pesos LoRA, ele funciona como um módulo de aceleração versátil e demonstrou sua compatibilidade com outros modelos personalizados nas comunidades de difusão estável. Para inferência, a estrutura AnimateLCM mescla os pesos do LoRA com os pesos originais sem corromper a velocidade de inferência. Depois que a estrutura AnimateLCM ganha o modelo de consistência no nível de geração de imagem, ela congela os pesos do modelo de difusão estável e os pesos LoRA nele. Além disso, o modelo infla os kernels de convolução 2D para os kernels pseudo-3D para treinar os modelos de consistência para geração de vídeo. O modelo também adiciona camadas temporais com inicialização zero e uma conexão residual em nível de bloco. A configuração geral ajuda a garantir que a saída do modelo não será influenciada quando for treinado pela primeira vez. A estrutura AnimateLCM sob a orientação de modelos de difusão de vídeo de código aberto treina as camadas temporais estendidas dos modelos de difusão estáveis.

É importante reconhecer que, embora os pesos espaciais do LoRA sejam projetados para agilizar o processo de amostragem sem levar em conta a modelagem temporal, e os módulos temporais sejam desenvolvidos por meio de técnicas de difusão padrão, sua integração direta tende a corromper a representação no início do treinamento. Isto apresenta desafios significativos na sua fusão eficaz e eficiente com o mínimo de conflito. Por meio de pesquisa empírica, a estrutura do AnimateLCM identificou uma abordagem de inicialização bem-sucedida que não apenas utiliza os antecedentes de consistência dos pesos LoRA espaciais, mas também mitiga os efeitos adversos de sua combinação direta.

No início do treinamento de consistência, os pesos LoRA espaciais pré-treinados são integrados exclusivamente ao modelo de consistência on-line, poupando a inserção do modelo de consistência alvo. Esta estratégia garante que o modelo alvo, servindo como guia educacional para o modelo on-line, não gere previsões erradas que possam afetar negativamente o processo de aprendizagem do modelo on-line. Ao longo do período de treinamento, os pesos LoRA são progressivamente incorporados ao modelo de consistência alvo por meio de um processo de média móvel exponencial (EMA), alcançando o equilíbrio de peso ideally suited após várias iterações.

Adaptação Gratuita do Professor

Modelos de difusão estável e adaptadores plug and play geralmente andam de mãos dadas. No entanto, foi observado que, embora os adaptadores plug and play funcionem até certo ponto, eles tendem a perder o controle dos detalhes, mesmo quando a maioria desses adaptadores é treinada com modelos de difusão de imagem. Para combater esse problema, a estrutura AnimateLCM opta pela adaptação gratuita do professor, uma estratégia simples, mas eficaz, que acomoda os adaptadores existentes para melhor compatibilidade ou treina os adaptadores desde o início. A abordagem permite que a estrutura AnimateLCM alcance a geração de vídeo controlável e a geração de imagem para vídeo com um número mínimo de etapas, sem a necessidade de modelos de professores.

AnimateLCM: experimentos e resultados

A estrutura AnimateLCM emprega um Steady Diffusion v1-5 como modelo base e implementa o solucionador DDIM ODE para fins de treinamento. A estrutura também aplica o Steady Diffusion v1-5 com pesos de movimento de código aberto como modelo de difusão de vídeo do professor com os experimentos sendo conduzidos no conjunto de dados WebVid2M sem quaisquer dados adicionais ou aumentados. Além disso, a estrutura emprega o conjunto de dados TikTok com breves prompts textuais legendados em BLIP para geração de vídeo controlável.

Resultados Qualitativos

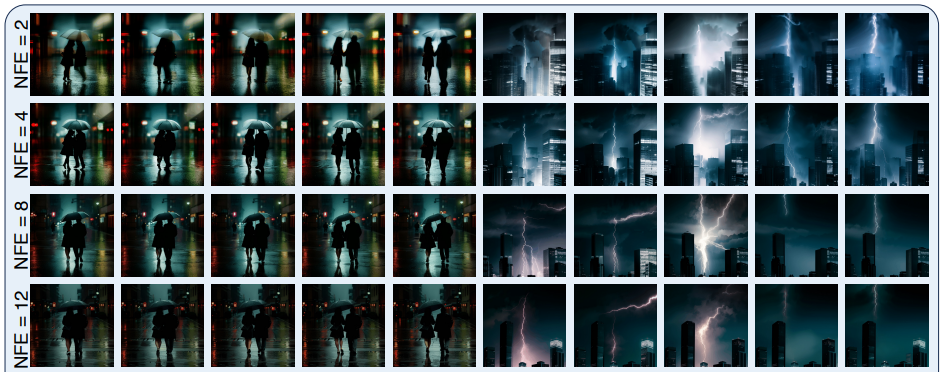

A figura a seguir demonstra os resultados do método de geração de quatro etapas implementado pela estrutura AnimateLCM na geração de texto para vídeo, geração de imagem para vídeo e geração de vídeo controlável.

Como pode ser observado, os resultados entregues por cada um deles são satisfatórios, com os resultados gerados demonstrando a capacidade do framework AnimateLCM de seguir a propriedade de consistência mesmo com etapas de inferência variadas, mantendo movimento e estilo semelhantes.

Resultados Quantitativos

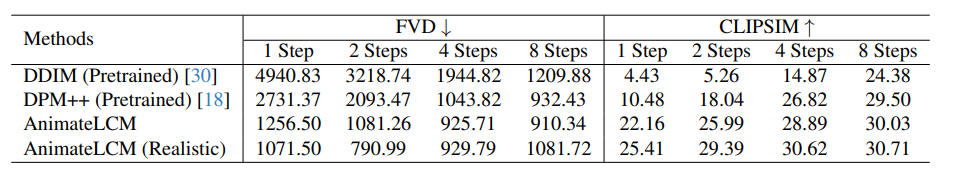

A figura a seguir ilustra os resultados quantitativos e a comparação da estrutura AnimateLCM com os métodos DDIM e DPM++ de última geração.

Como pode ser observado, a estrutura AnimateLCM supera os métodos existentes por uma margem significativa, especialmente no regime de passos baixos, variando de 1 a 4 passos. Além disso, as métricas do AnimateLCM exibidas nesta comparação são avaliadas sem o uso do CFG ou da orientação gratuita do classificador, o que permite que a estrutura economize quase 50% do tempo de inferência e do custo de memória de pico de inferência. Além disso, para validar ainda mais o seu desempenho, os pesos espaciais dentro da estrutura do AnimateLCM são substituídos por um modelo realista personalizado disponível publicamente que atinge um bom equilíbrio entre fidelidade e diversidade, o que ajuda a aumentar ainda mais o desempenho.

Pensamentos finais

Neste artigo falamos sobre o AnimateLCM, um modelo de difusão personalizado com adaptadores que visa gerar vídeos de alta fidelidade com mínimos passos e custos computacionais. A estrutura AnimateLCM é inspirada no Modelo de Consistência, que acelera a amostragem com etapas mínimas, destilando modelos de difusão de imagem pré-treinados, e na extensão bem-sucedida do Modelo de Consistência, Modelo de Consistência Latente ou LCM, que facilita a geração de imagens condicionais. Em vez de conduzir o aprendizado de consistência diretamente no conjunto de dados de vídeo bruto, a estrutura do AnimateLCM propõe usar uma estratégia de aprendizado de consistência desacoplada que dissocia a destilação de anteriores de geração de movimento e anteriores de geração de imagem, permitindo que o modelo melhore a qualidade visible do conteúdo gerado, e melhorar a eficiência do treinamento simultaneamente.